De ongemakkelijke waarheid over AI: geniaal, maar fundamenteel onbetrouwbaar

De nieuwste AI-modellen kunnen wiskundige vraagstukken oplossen, programmeren en bruikbare zakelijke adviezen geven. Toch blijft deze technologie, die erg krachtig is, fundamenteel onbetrouwbaar. Dat stelt lector Pascal Wiggers van de Hogeschool van Amsterdam in zijn lectorale rede op donderdag 30 oktober. “Het maakt fouten op onvoorspelbare momenten, kan waarheid niet van onwaarheid onderscheiden en heeft geen notie van betekenis. Deze tekortkomingen zullen nooit volledig verdwijnen.”

Wiggers gaat met zijn analyse in tegen het beeld dat grote techbedrijven schetsen. Zij gokken erop dat de biases en fouten in AI-modellen uiteindelijk zullen verdwijnen. De profeten van Silicon Valley(opent in nieuw venster) voorspellen dat het een kwestie van tijd is voordat AI een breed scala aan taken kan begrijpen, leren en uitvoeren op menselijk- of zelfs bovenmenselijk niveau, zogenaamde superintelligentie(opent in nieuw venster).

AI-modellen worden beter door grotere rekenkracht

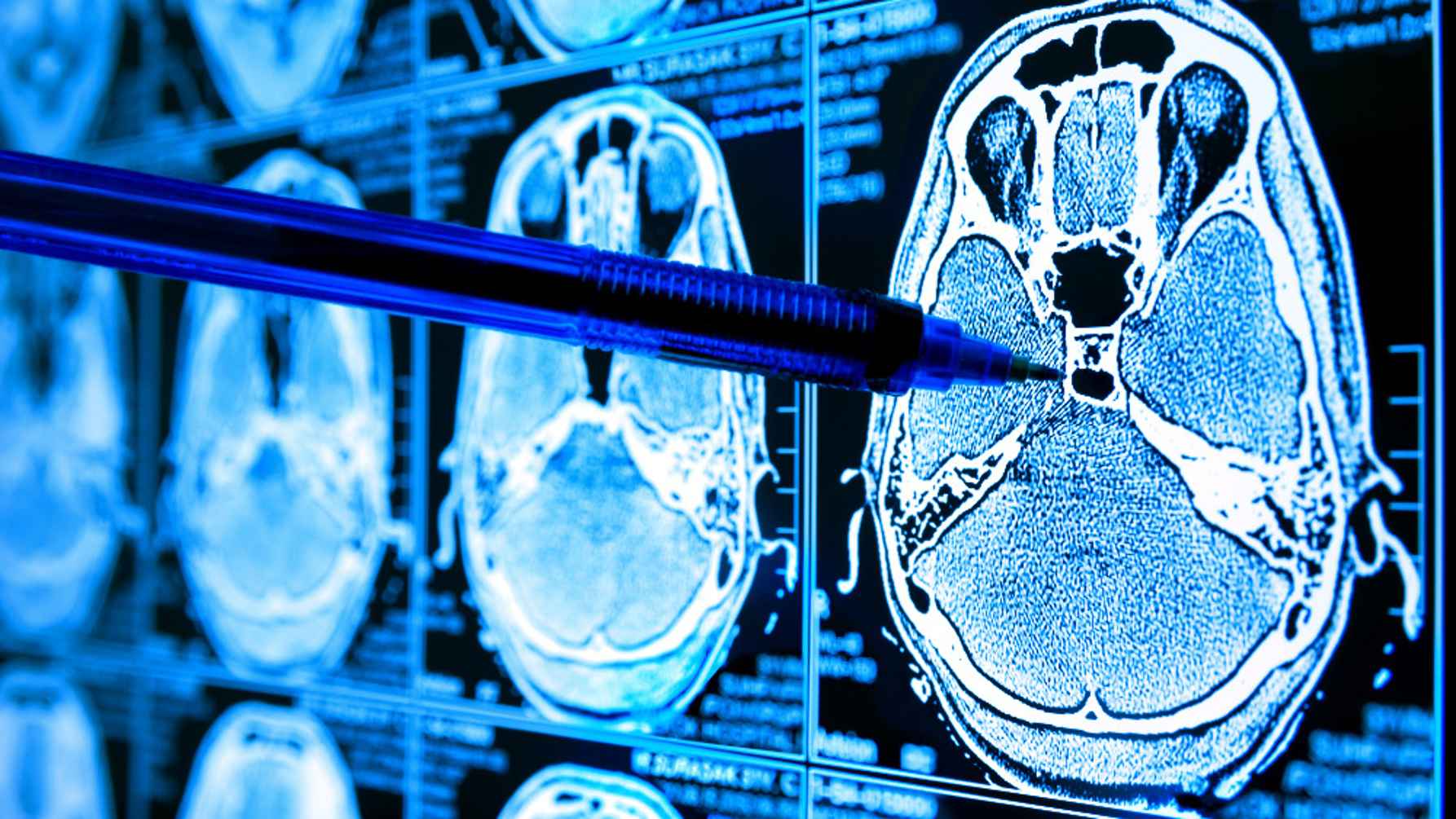

Allereerst constateert Wiggers dat de mogelijkheden van de meest geavanceerde AI-modellen nauwelijks te overschatten zijn. Kunstmatige intelligentie is, zoals bekend, sterk in het ontdekken van patronen die ons met het blote oog of met andere technologieën ontgaan. Zo kan het op röntgenfoto’s vroege aanwijzingen voor tumoren vinden, of de 3D-structuur van proteïnes nauwkeurig voorspellen.

Intussen zijn grote redeneermodellen ook al in staat om filosofische discussies te voeren en complexe wiskundige vraagstukken op te lossen.

Proeven onder de motorkap

Wetenschappers proberen te achterhalen wat er ‘onder de motorkap’ gebeurt bij deze AI-modellen. Wiggers beschrijft in zijn rede hoe de onderliggende technologie werkt, en op welke manieren onderzoekers zicht krijgen op wat er binnenin de technologie gebeurt.

Opvallend is dat deze grote, geavanceerde AI-modellen niet alleen patronen uit data halen. Ze lijken tijdens hun training namelijk ook ‘metakennis’ te ontwikkelen: abstracte kennis over taal en nieuwe strategieën om vragen op te lossen.

Die metakennis is niet voorgeprogrammeerd, maar ontstaat door het verwerken van enorme hoeveelheden data (mits het model groot genoeg is).

Bijna (maar geen echte) menselijke redeneervermogens

Het is verleidelijk om hierin haast menselijke redeneervermogens in te zien, beschrijft Wiggers. Maar tegelijk gaan diezelfde geavanceerde modellen bij ogenschijnlijk triviale vragen nog steeds volledig onderuit.

Wiggers haalt in zijn rede een simpele variatie op een bekende puzzel aan (hoe je met een wolf, geit, kool een rivier oversteekt). ChatGPT komt met een antwoord dat past bij het bekendste raadsel, maar geeft telkens geen juist antwoord op deze specifieke vraag.

Fouten en goede resultaten lopen door elkaar

Modellen slaan, met dezelfde zelfverzekerdheid waarmee ze een heldere analyse bieden, het volgende moment weer onzin uit. “En het lastige is: de keren dat het fantastisch goed of fout gaat, lopen door elkaar”, aldus Wiggers. “Of het gebeurt tegelijkertijd.”

Fouten verbonden met werking AI

In zijn rede legt Wiggers uit dat de fouten inherent zijn aan de manier waarop AI (door middel van machine learning) leert en werkt. Statistische modellen neigen naar gemiddelden - hoe vaker een patroon voorkomt, hoe meer het ingesleten raakt. Ze zijn daardoor nooit 100 procent betrouwbaar, want ze kennen niet alle situaties die in de praktijk voorkomen.

Ook kunnen statistische AI-modellen niet goed overweg met uitzonderingen en bijzonderheden. Minderheden vallen daardoor vaker buiten de boot. En als je die ene sollicitant bent met een wat afwijkend, maar interessant cv, dan is de kans grootdat een AI-systeem je automatisch afwijst(opent in nieuw venster).

Onjuiste verbanden

Daarnaast kan een AI-model verbanden leggen die in werkelijkheid niet bestaan, of die samenhangen met factoren buiten het model. Een bekend voorbeeld is een systeem dat moest voorspellen of mensen met longontsteking in het ziekenhuis moesten worden opgenomen. Het AI-model stuurde patiënten met zowel longontsteking als astma ten onrechte naar huis (omdat deze mensen in de praktijk vaak meteen naar de IC gaan).

Wordt een model (indirect) bijgestuurd op resultaten die het zelf heeft veroorzaakt, dan ontstaan feedbackloops. Het gevolg is een zichzelf versterkend, steeds smaller beoordelingskader.

Geen notie van betekenis

Ook cruciaal: AI heeft geen notie van betekenis. Een taalmodel bootst taalgebruik na door verbanden te leggen tussen woorden en soms beelden. Maar het heeft geen besef van betekenis of waarheid.

Wiggers: “Het heeft geen toegang tot die informatie, omdat die vaak fysiek en impliciet is, ingebed in onze omgang met elkaar en met de wereld.”

Generatieve AI mist elk gevoel voor betekenis die wij aan dingen geven

Keerzijden van succes AI

De genoemde fouten en vooroordelen zijn geen kleine foutjes die simpel te repareren zijn. Het zijn keerzijden van het succes van AI.

Want juist doordat AI statistisch werkt, kan het omgaan met onvolledige informatie, en taken uitvoeren zoals spraakherkenning en vertalen, die we met andere digitale technologieën niet weten te realiseren. Maar diezelfde statistische basis zorgt ook voor ongewenste patronen, en een blinde vlek voor uitzonderingen.

"Deze effecten zijn deels te verminderen, en het is belangrijk dat te doen. Maar de bottom line: het wordt beter, maar nooit helemaal goed”, concludeert Wiggers.

Het maakt fouten op onvoorspelbare momenten, kan waarheid niet van onwaarheid onderscheiden en heeft geen notie van betekenis. Deze tekortkomingen zullen nooit volledig verdwijnen. Nadenken is de enige remedie.

Pascal Wiggers

Lector Responsible IT

In de praktijk

Volgens Wiggers krijgt AI pas echt betekenis in de praktijk, waar technologie onzichtbaar lijkt zolang het werkt, maar tegelijk ons handelen stuurt en beïnvloedt. Daarom is het cruciaal dat we AI juist in de maatschappelijke context onderzoeken. Wat doet de technologie met de praktijk zelf? Wat betekent ze voor betrokken mensen en onze relaties?

Verantwoorde AI

Verantwoord is een werkwoord, besluit Wiggers – we moeten continu wegen en bijsturen. Om deze snel veranderende technologie goed te leren kennen, is experimenteren essentieel. Dit betekent niet alleen 'spelen met', maar ook bereid zijn om bij nader inzien terug te keren op onze schreden, of in bepaalde gevallen bewust AI níet in te zetten.

"Het is nodig dat we continu monitoren, en expliciete gesprekken voeren over wat we waardevol vinden en hoe AI hierop ingrijpt."

Dat geldt ook voor de ontwikkeling van AI zelf, zegt Wiggers. In plaats van mee te gaan in het verhaal van steeds slimmer wordende technologie van big tech, zouden we AI-toepassingen moeten ontwerpen vanuit wat we waardevol vinden — en hoe deze technologie daarin een verantwoorde plaats kan krijgen.

Kritisch vakmanschap is hard nodig

Mensen die opgeleid zijn in ICT, technologie en media blijven dan ook hard nodig. Vakmanschap blijft; maar de maker wordt nu meer een regisseur. Om AI-uitkomsten goed te kunnen beoordelen op waarheid, volledigheid en toepasbaarheid – en om te weten wanneer AI níet moet worden ingezet. “Kritisch vakmanschap wordt nog belangrijker dan het was.”

Pascal Wiggers houdt zijn lectorale rede ‘Prachtige onbetrouwbare technologie’ op donderdag 30 oktober, 16-17 uur. De rede is te volgen via livestream.